Eine kollaborative Auswertung verteilter sensibler Daten für die Forschung und den Datenschutz – wie geht das zusammen? Das Berliner Deep-Tech-Start-up apheris AI zeigt, wie es geht!

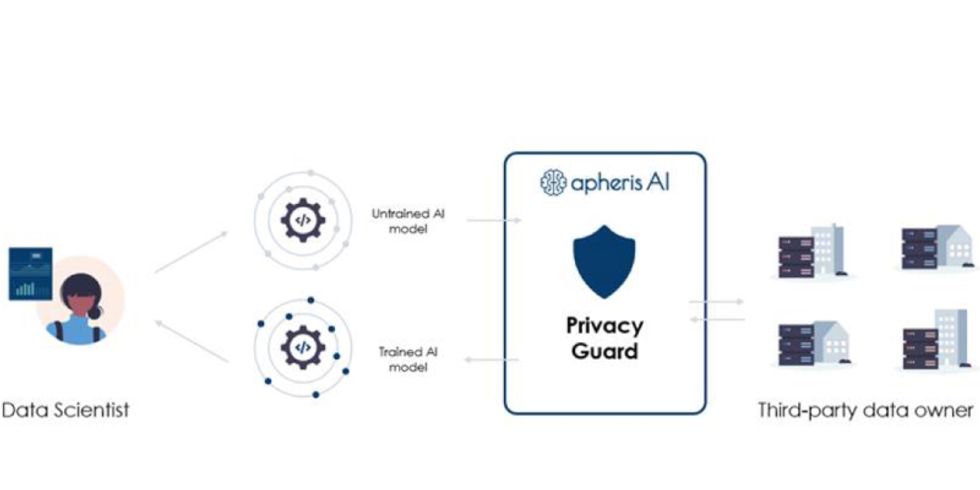

Das Deep-Tech-Unternehmen apheris AI ging vor einem Jahr mit zwei Visionen an den Start, die bislang eher unvereinbar schienen: auf verschiedene Institutionen verteilte Informationen gemeinsam für die Forschung zu nutzen und dabei gleichzeitig effektiv und angriffssicher Datenschutz und geistiges Eigentum zu wahren. Das Angebot an forschende Unternehmen ist ein „Datenschutz bewahrendes Daten-Ökosystem“.

Zum Hintergrund: Die Basis von Forschung und Innovation bilden heute immer mehr Daten, Daten, Daten. Um den oft komplexen Datensätzen nutzbringende Erkenntnisse zu entlocken, erfolgen die Analysen in der Regel auf Basis von Künstlicher Intelligenz und Maschinellem Lernen.

Um Modelle des Machine Learning zu entwickeln, sind möglichst große und vielfältige Datensätze erforderlich. Denn das künstliche System trainiert mit den Daten, mit denen man es speist, und generiert daraus Erfahrungswissen: Muster, Gesetzmäßigkeiten, Trends, Statistiken. Dies geschieht mit Hilfe von Algorithmen. Qualität und Erfolg der Machine-Learning-Algorithmen sind dabei abhängig von den zur Verfügung stehenden relevanten Trainingsdaten.

Potenzial für Forschung und Innovation freilegen

Das Problem: Ob es sich um sensible Patient*innendaten für klinische Studien oder für biomedizinische Forschung in Unternehmen handelt – Wissenschaftler*innen und Unternehmen können datenschutzrechtlich oft nur mit ihren eigenen, manchmal schmalen Datensätzen arbeiten. Und diese sind, separat betrachtet, oft nicht aussagekräftig genug.

„Zu oft werden kritische Daten in Silos weggeschlossen oder aus Datenschutz- oder Sicherheitsbedenken nicht gemeinsam genutzt“, sagt Robin Röhm, Mitbegründer und CEO des Berliner Start-ups apheris AI. „Das verhindert wertvolle Erkenntnisse und neue Lösungen. Eine gemeinsame Datenauswertung verschiedener Organisationen ist essentiell für die Bekämpfung der größten Probleme unserer Zeit, einschließlich der Corona-Pandemie.“

Die Macher von apheris AI sind überzeugt, dass die Zusammenarbeit von Unternehmen an dieser Stelle wertvolles Potenzial für Forschung und Innovation freilegen kann.

Machine Learning für die Arzneimittelbranche

Besonders schwierig ist die gemeinsame Analyse von verteilten Daten im Gesundheitssektor. Denn hier handelt es sich um teils hochsensible Patient*inneninformationen, die unter strengem Datenschutz stehen. „Dennoch sind diese Daten für die Wissenschaft notwendig, um medizinische Lösungen zu entwickeln und damit Patient*innen zu helfen“, erklärt Röhm. „Wir wollen Institutionen und Firmen dabei helfen, gemeinsam ihre Daten auszuwerten, ohne dabei die Privatheit der Daten zu verletzen.“

Zugute kommen könnte dies zum Beispiel der Arzneimittelforschung. Hierbei hat die Entwicklung von Machine-Learning-Modellen ein großes Anwendungsspektrum: vom Generieren neuartiger Molekularstrukturen über die Vorhersage von Krankheiten oder toxikologischen Wirkungen bis hin zur Analyse medizinischer Bildgebung oder zur Wechselwirkung von Medikamenten.

Datenaustausch: dezentralisiert und föderiert

Datenschutz in Wissenschaft und Forschung basiert bislang häufig auf der Anonymisierung von Patient*innendaten. Dass hierbei jeder Personenbezug aus den Daten gestrichen wird, reduziert jedoch auch die Aussagekraft der jeweiligen Daten. Röhm sieht zudem Sicherheitslücken: „Der Angriffsvektor ist bei anonymisierten Daten relativ groß. Durch Daten-Matching lassen sich einzelne Daten oft durchaus reidentifizieren.“